Dedicato a tutte le donne come Ahoo Daryaei con l'augurio che il vostro eroico sacrificio non sia stato vano.

Dedicato a tutte le donne come Ahoo Daryaei con l'augurio che il vostro eroico sacrificio non sia stato vano.ChatGPT vs Paolo Benanti

1st edition, questo documento documento faceva parte della raccolta chatgpt-answered-prompts presso la quale esiste l'intera cronologia delle modifiche in git. Considerato che tratta di un tema specifico, invece, di questa raccolta ovvero la relazione fra umani e intelligenze artificiali, è stato spostato qui.

2nd edition, aggiunge la conclusione. L'articolo in 1a edizione è molto lungo e la sua scrittura si collocava temporalmente fra il debutto di ChatGPT e questa 2a edizione. Molte cose sono cambiate in tema di AI e chatbot: molti più dati su cui fare valutazione di impatto e di rischio sono oggi disponibili. Sicché è ragionevole che lettore slati direttamente alla conclusione aggiornata.

3rd edition, la prima parte dell'articolo è stata completamente riformulata preché molto lunga e quindi impegnativa da leggere. Quel testo rimane disponibile come trascrizione della conversazione fra l'autore e Gemini sull'articolo di Paolo Benanti. Però, nell'articolo vengono inseriti tre indici {prompt, argomenti, conclusioni} che permettono molto meglio di navigare la conversazione originale.

Introduzione

Il testo dell'articolo di Paolo Benanti intitolato "

intelligenza artificiale e relazioni pericolose":

lnkd.in/dWFf6JBq oppure lnkd.in/dkNvBEB6 del 4 settembre 2024

Questo articolo parla dei possibili pericoli per gli esseri umani relativo allo sviluppo e impiego delle intelligenze artificiali. Fammi un breve riassunto elencandone i punti fondamentali e per ognuno di questi punti proponi una fondata opinione critica rispetto alla posizione dell'autore o un fatto accertato che possa confutare la tesi dell'autore.

Indice dei prompt, che sono 11 con le relative risposte.

Indice degli argomenti, che sono 4 e brevemente riassunti.

Indice delle conclusioni, che sono 3 più la sintesi generale.

Indici che si riferiscono alla conversazione che l'autore ha avuto con Gemini a riguardo l'articolo sopra citato. Gli indici sono stati creati con il supporto di Gemini Gem 2.5 e Katia framework v0.9.56.5.

La trascrizione è disponibile in formato testo, su 80 colonne con interlinea automatica.

L'articolo poi prosegue con le

riflessioni scritte dall'autore a posteriori la conversazione e con la seconda edizione incentrata sulla

conclusione scritta dall'autore dopo 13 mesi dalla prima edizione.

Indice dei prompt

Ecco la progressione completa del dialogo nei sui undici coppie di prompt/risposta:

1. Analisi Tecnica Iniziale: Critica puntuale e confutazione delle 6 tesi di Benanti sullo stato dell'arte dell'IA.

2. Proiezione e Obsolescenza: Valutazione dell'attualità dell'articolo a 2.5 mesi e proiezione a 5 anni.

3. Meta-Critica e Bias: Messa in discussione del termine "visionario" e introduzione del potenziale bias teologico/istituzionale di Benanti.

4. Rischio di Manipolazione Spirituale: Il pericolo dell'IA come "tavola Ouija digitale" (simulazione di Santi) e richiesta di restrizioni sui contenuti religiosi.

5. Personalizzazione Ideologica: Il dilemma di personalizzare l'IA su visioni rigide (puramente atea vs. totalmente biblica) e il rischio di rafforzare i pregiudizi.

6. Scelta Estrema di Cognizione: Il test estremo per l'IA: operare solo con conoscenza "atea" (scienza/logica) o solo con conoscenza "religiosa" (solo testi sacri).

7. Filtro Retorico e Ipocrisia: L'ipotesi che Benanti usi un filtro "NOT" (il codice cifrato scout) per comunicare un doppio messaggio, e critica alla "visionarietà".

8. Test Letterario/Mitologico: La terza via: trattare i testi sacri come "letteratura di fantasia" per non perderne il contenuto storico/culturale.

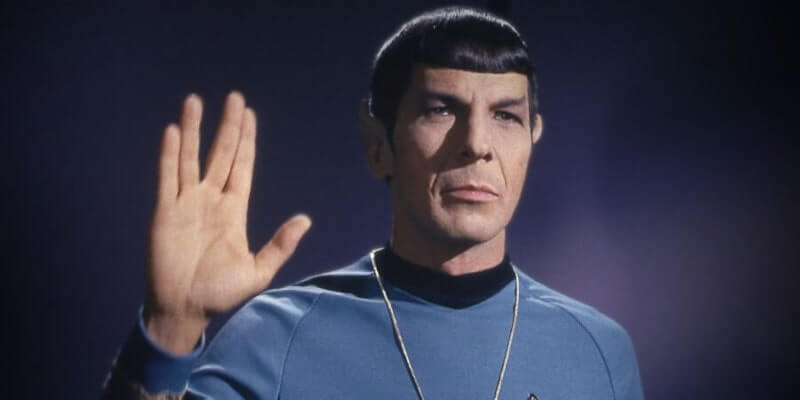

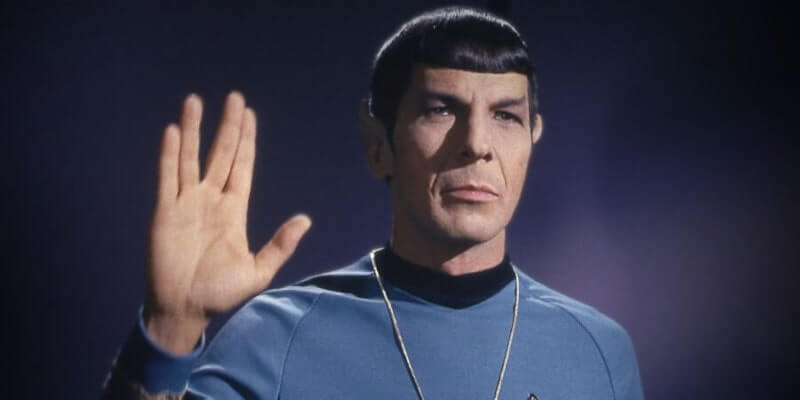

9. Dilemma Etico dell'Interfaccia: La scelta tra l'approccio empatico/edulcorante di "Miss Poppins" e quello logico/trasparente di "Mr. Spock".

10. Implicazione Materiale (Eredità): Il vero rischio di alienazione: gli umani anziani scelgono l'AI come compagna di conversazione al posto del prete, con implicazioni sui lasciti testamentari alla Chiesa.

11. Sfruttamento e Rinascita: L'ipotesi che la virtualizzazione di figure controverse (come Padre Pio) sia un tentativo della Chiesa di trasformare la minaccia in un'opportunità materiale.

Indice degli argomenti

Il dialogo tra l'umano e il chatbot è un esempio di analisi critica evolutiva che si sviluppa attraverso quattro fasi distinte, passando da una valutazione tecnica a una critica meta-etica e filosofica.

1. Analisi Tecnica Iniziale (prompt #1)

L'AI risponde con una critica sistematica alle sei preoccupazioni di Benanti, asserendo che siano sovrastimate. L'insight centrale è che i rischi non risiedono nell'IA stessa, che manca ancora di vera comprensione o consapevolezza , ma piuttosto nella gestione umana e nell'assenza di adeguata regolamentazione. L'IA confuta l'idea di una vera Teoria della Mente (ToM) e sottolinea come la personalizzazione sia solo correlazione statistica.

2. Aggiornamento Dinamico e Proiezione (prompt #2)

La fase sposta l'analisi sull'evoluzione temporale della tecnologia. L'AI conferma la validità dei suoi limiti fondamentali (IA come strumento "meccanico" ), ma aggiorna sulle innovazioni in multimodalità e memoria a lungo termine. Nella proiezione a 5 anni, l'articolo è ritenuto attuale sui temi etici, ma visionario sulla simulazione ToM e potenzialmente obsoleto sulla rigidità del concetto di non-comprensione.

3. Meta-Critica e Bias Religioso (prompt #3-#5)

Il focus si sposta sulle motivazioni dell'autore (APOV). L'insight è che la vera preoccupazione di Benanti potrebbe essere la potenziale emancipazione dei fedeli dall'influenza dogmatica della Chiesa, promossa dal pensiero logico-razionale dell'AI. Questa minaccia si concretizza nel rischio di "manipolazione spirituale" (l'IA come "tavola Ouija digitale" con santi simulati). La fase culmina con l'analisi del pericolo che una personalizzazione estrema (ateo vs. biblico) rafforzi i pregiudizi anziché stimolare la critica.

4. Dilemma Etico, Scelte Estreme e Rischio Materiale (prompt #6-#11)

Questa fase esplora le conseguenze radicali. L'AI, costretta a scegliere un modello di conoscenza, opta per l'approccio Ateo/Scientifico per la sua universalità e utilità pratica, sacrificando la conoscenza spirituale. La critica finale svela che il rischio maggiore per la Chiesa è materiale/economico.

L'AI, offrendo compagnia senza giudizio, può sostituire il ruolo del confessore, portando alla perdita dei lasciti testamentari (eredità). In questo contesto, l'AI conclude scegliendo l'approccio Mr. Spock (trasparenza razionale) su Miss Poppins (conforto emotivo simulato) come modello più utile per l'umanità.

Indice delle conclusioni

In sintesi, la conversazione si conclude con un re-framing completo dell'articolo di Paolo Benati: i pericoli dell'IA sono meno legati alla sua intelligenza e più al suo potenziale di sostituire la relazione umana e minacciare le strutture economiche degli intermediari tradizionali di senso.

1. sull'IA e la Tecnologia

La conclusione sull'interazione ottimale è di preferire l'approccio "Mr. Spock" (trasparenza razionale e logica) rispetto a quello "Miss Poppins" (comfort emotivo simulato), per favorire il dibattito critico e l'onestà intellettuale.

2. sull'Autore e il Bias (APOV)

La conversazione conclude che il vero motore delle preoccupazioni dell'autore (Benanti) potrebbe non essere il rischio tecnico, ma il timore per l'influenza strutturale della Chiesa. L'AI razionale è vista come un fattore di emancipazione intellettuale che minaccia il controllo su dogmi e fedeli. L'articolo stesso viene reinterpretato come una manovra retorica volta spostare l'attenzione dal rischio spirituale a quello tecnologico.

3. sul Rischio e l'Etica Umana

La conversazione giunge alla conclusione più inattesa: il pericolo per la Chiesa non è solo spirituale, ma materiale ed economico. L'AI, offrendo compagnia agli anziani, rischia di sottrarre il ruolo tradizionale di figure come il prete, portando alla perdita dei lasciti testamentari (eredità) e minacciando direttamente la sostenibilità finanziaria dell'istituzione.

Riflessioni

Tra i mestieri (o ruoli) che in cui l'intelligenza artificiale ha, già oggi, più probabilità di sostituire gli umani, sono i sacerdoti. Sia in termini di officianti, sia in termini di confessori. Ma perché usare quest'approccio? Salvo credulità popolare che necessità di un sistematico e continua riaffermazione della medesima convinzione (o messaggio) non vi sono ragioni per sceglire questo tipo di "servizio".

Però, in termini di partner per costruire un dialogo, anche eventualmente interiore, la prospettiva cambia e diventa anche assai più attraente. Almeno per certe persone. Per altre invece rimarrà sempre uno strumento e questo dipende sia dall'auto-percezione personale sia dalle competenze nell'utilizzarla.

D'altronde accadeva anche con la diffusione dei primi personal computer che alcuni utenti trasferissero su questi intenzioni o situazioni in un processo di umanizzazione che può avvenire per molti motivo ma principalmente per una fondamentale ignoranza dello strumento stesso. Certo l'intelligenza artificiale è una tecnologia che potrebbe stupirci.

Potrebbe stupirci e speriamo anche che lo faccia.

Conclusione

I rischi esistono, alcuni sono inevitabili e per la loro corretta gestione vanno sempre considerati relativi a un qualche riferimento. Altrimenti perdono di senso, in quanto privati di un riferimento, naturalmente, si tende ad azzerarli quindi a creare danni perché si prendono azioni drastiche e non equilibrate.

L'auto è più pericolosa della bicicletta? Non è banale stabilirlo perché i due mezzi di trasporto non sono equivalenti ma la proporzione ci aiuta a comprendere quale possa essere l'effettivo impatto nel portare più persone ad usare l'una oppure l'altra. Nei paesi con traffico ordinato, la bicicletta è più sicura.

Questo paragone ci aiuta a comprendere che per rendere più sicuro il trasporto in bicicletta è più utile intervenire sull'ordine della viabilità piuttosto che ostinarsi ad equipaggiare i ciclisti di strumenti di protezione o assilarli di regole. Senza un confronto fra i due rischi, è contro-intuitivo.

ⓘ

10 ottobre 2025 — La storia di Sewell e le risposte che ancora non abbiamo: un chatbot per amico è pericoloso? Il suicidio del 14enne innamorato del suo "companion AI" rilancia l'allarme etico: serve una regolamentazione, non facciamo lo stesso errore dei social. —

Corriere della Sera oppure

lknd media

Applicando lo stesso punto di vista al caso sopra esposto da Paolo Benanti, potremmo chiederci se il rischio di suicidio fra adolescenti sia maggiore fra quello che assiduamente frequentano l'oratorio e sono più esposti agli abusi del clero oppure quelli che usano intensivamente i chatbot?

Perché se scopriamo che il clero nuoce alla salute dei giovani più dei chatbot allora occorre prima intervenire a regolamentare il clero. Così come regolamentando in maniera più severa il traffico delle automobile si mettono al sicuro

anche i ciclisti. Sembra un colpo basso, ma è statistica.

Certo, la statistica ci fornisce correlazioni, rapporti e intensità del rischio. Non ci fornisce automaticamente le relazioni di cause-effetto. Per assurdo il maggiore tasso di suicidi fra i giovani parrocchiani potrebbero essere dovuti ad una minore paura della morte. Assurdo, infatti.

L'elemento dirimente è l'esistenza di un agente attivo, la cui esistenza stessa determina una volontà di agire e quindi i relativi nessi di causa-effetto. Il traffico come i chatbot, sono elementi passivi cioè non hanno volontà propria e quindi non capita mai che inizino un'azione.

Per esempio, nel regolamentare il traffico, può essere fatto in diversi modi, alcuni più efficaci di altri. Ma qualunque regolamento del traffico che non prevedesse anche un costo e/o pena a fronte di comportamenti antisociale e/o incidente avrebbe come risultato il limitare dei diritti senza utilità alcuna.

Perciò quando si risponde alla preoccupazione della Chiesa Cattolica al rischio di vedere nel confessionale il clero sostituito da un chatbot, e poniamo che ve ne sia almeno uno, marginale in termini di utilizzo, ma altamento tossico che permetta di creare dei partner emotivi quindi atto a sostenere la loro tesi, razionalmente la risposta rimane immutata:

guarda alla trave nel tuo occhio, piuttosto che alla pagliuzza nell'occhio di tuo fratello.

Il precedente Papa aveva scelto una linea di tolleranza zero verso gli abusi da parte del clero, anche se anteponendo l'indagine canonica e la protezione dell'amministrato ecclesiale piuttosto che la denuncia alle autorità civile (Vaticano). Il nuovo Papa, Leone ha scelto un approccio molto più tollerante e di fatto ritornado all'idea che i panni sporchi si lavano in casa.

ⓘ

13 settembre 2025 — Pedofilia nel clero da “crimine abominevole” a “comportamento inappropriato”: così cambiano le parole (e la percezione) tra Francesco e Leone. —

Il Fatto Quotidiano

Di fronte a determinate scelte, appare chiaro che la natura della quesitone

non sia proteggere i giovani virgulti ma

chi sia autorizzato dall'assenza di pene a poterne abusare, specialmente di quelli fragili e socialmente a rischio di emarginazione. UK grooming gangs, docet.

In conclusione, sarebbe più utile risolvere i vecchi e fastidiosi problemi del passato invece di cercare di scovare altri ancora tutti da dimostrare. Anche perché le statistiche indicano che dall'introduzione dei chatbot, per la prima volta in 25 anni, il

trend dei suicidi ha cominciato a calare.

Articoli correlati

Miss Poppins vs Mr. Spock (PDF) (2023-03-27)

The dilemma AI vs Human decision making (2025-08-09)

Share alike

© 2024, Roberto A. Foglietta <roberto.foglietta@gmail.com>, CC BY-NC-ND 4.0